«What exactly is mathematics ? Many have tried but

nobody has really succeeded in defining mathematics ;

it is always something else».

Stanisław Marcin Ulam,

Adventures of a Mathematician, 1976.

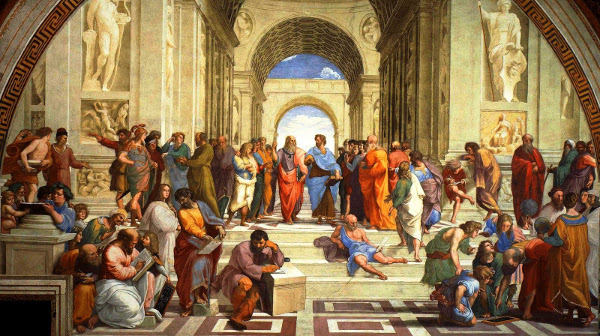

Les mathématiques sont probablement issues historiquement des préoccupations de la vie quotidienne. Le besoin de compter, de déterminer des proportions, de quantifier des surfaces et des volumes, de répartir un héritage, de fluidifier des échanges économiques, de mettre au point des calendriers, de prédire l’astronomie, autant de raisons d’introduire et de développer les mathématiques. Cet ancrage numérique et géométrique, lié à la mesure de l’espace et du temps, est bien visible chez les peuples de l’Antiquité, qui n’en sont pas moins déjà très attirés par les abstractions dépouillées.

Inspirés au départ par le concret, les mathématiciens ont construit peu à peu un monde parallèle abstrait et idéal. Ce monde esthétique, fait de concepts et de raisonnements logiques, a fini par acquérir une véritable autonomie au fil du temps. Ce détachement du réel permet l’épure de la pensée. C’est ce monde au langage universel que les mathématiciens partagent et explorent aujourd’hui. La géométrie plane d’Euclide en fournit une belle illustration. Les droites et les cercles d’Euclide sont des êtres mathématiques, des concepts obtenus en épurant et en idéalisant la réalité. Cette manière de procéder est suggérée par notre perception du réel. Les mathématiques sont le résultat naturel des capacités sensorielles et cognitives humaines. Elles constituent une formalisation communicable et utilisable de notre appréhension du monde. Les théorèmes de Pythagore et de Thalès, obtenus par la pensée logique dans le cadre idéal de la géométrie plane d’Euclide, s’avèrent remarquablement utiles dans le monde réel. Passer par l’idéalisation permet un progrès concret. Le phénomène est également visible dans la découverte, au XIXe siècle, des géométries non euclidiennes en mathématiques, puis hors des mathématiques.

Au fil du temps, les mathématiques sont devenues le langage de la physique, avec une efficacité stupéfiante, tandis que, réciproquement, la physique demeure une profonde source d’inspiration pour les mathématiques. Notre vie quotidienne serait bien différente sans les théories mathématisées d’Isaac Newton, Albert Einstein, James C. Maxwell et Claude Shannon, pour ne citer qu’elles. La distinction faite parfois entre mathématiques fondamentales et mathématiques appliquées est artificielle et manque de pertinence face à la réalité de la science elle-même, bien qu’elle puisse correspondre à l’organisation des mathématiciens à l’échelle individuelle et sociale. Par ailleurs, l’utilité des mathématiques ne doit pas faire oublier qu’elles sont aussi un art créatif de la pensée, avec ses artistes, ses esthétiques et ses controverses. Les mathématiques constituent enfin un immense terrain de jeux intellectuels, pour petits et grands.

Et les probabilités, dans tout ça ?

En guise de clin d’œil à Jacques Monod, il est plutôt plaisant de souligner que les probabilités se sont imposées à la fois en physique et en mathématiques comme une nécessité. De nos jours, ce qu’on appelle « théorie des probabilités » constitue une branche incontournable des mathématiques, au même titre que l’algèbre, l’analyse ou la géométrie. De conception tardive, cette branche est très connectée à toutes les autres.

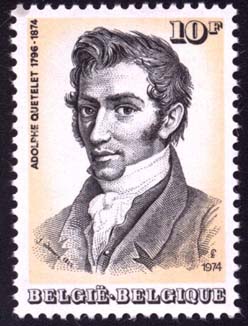

Les mathématiques se sont préoccupées au départ de problèmes déterministes, dans lesquels les informations initiales permettent d’élaborer des solutions déterminées, comme dans les théorèmes de Pythagore et de Thalès. Cette approche ne fonctionne plus lorsque le problème met en jeu des ingrédients imprévisibles, ce qui est le cas typiquement des jeux de cartes ou de dés. C’est d’ailleurs l’étude des jeux de hasard qui a conduit, dès le XVIIe siècle, avec notamment Blaise Pascal, Pierre de Fermat, Jacques Bernoulli, Abraham de Moivre et Thomas Bayes, à développer les prémisses d’une théorie des probabilités fondée sur la combinatoire. Les probabilités sont alors un art du calcul des proportions entre ensembles des possibles. Cette approche simple permet déjà d’aborder le jeu de hasard de la génétique au cœur des travaux à venir de Gregor Mendel. Dans son livre Théorie analytique des probabilités paru au début du XIXe siècle, Pierre-Simon de Laplace explique que « la théorie des hasards consiste à réduire tous les événements du même genre, à un certain nombre de cas également possibles, c’est-à-dire, tels que nous soyons également indécis sur leur existence ; et à déterminer le nombre de cas favorables à l’événement dont on cherche la probabilité. »

Avant l’avènement de la mécanique quantique, certains scientifiques, à l’image de Pierre-Simon de Laplace, concevaient le hasard comme l’expression de l’ignorance des causes. L’idée est la suivante : si nous avions accès aux conditions initiales du jet de dé ainsi qu’aux caractéristiques du dé avec suffisamment de précision, alors nous pourrions prévoir l’évolution de sa trajectoire et donc sa position finale en utilisant les équations du mouvement de Newton. Comme ces informations ne sont pas accessibles en général, la position finale du dé apparaît comme imprévisible, hasardeuse, aléatoire, stochastique (terme d’origine grecque utilisé en mathématiques). Cette vision incite à penser qu’il pourrait en être de même pour la position à long terme des planètes dans le système solaire, mais nous ne n’en dirons pas plus ici.

L’un des premiers à passer outre cette limitation fut sans doute Ludwig Boltzmann, en plein XIXe siècle. La thermodynamique, à l’époque à peine née des travaux de Sadi Carnot et de Rudolf Clausius, stipule que l’énergie interne totale d’un système physique isolé est conservée au cours du temps (premier principe), tandis qu’il existe une mesure du désordre, appelée « entropie », qui ne peut qu’augmenter au cours du temps (second principe). Boltzmann souhaite déduire le second principe du premier par le raisonnement, en utilisant une hypothèse atomiste controversée à l’époque. Pour fixer les idées, Boltzmann considère un gaz isolé dans une enceinte. En supposant que le gaz est constitué de particules atomiques1, chaque particule est l’analogue d’un dé et il y en a un nombre astronomique. L’idée géniale de Boltzmann est de considérer non plus l’évolution au cours du temps de l’ensemble des positions et vitesses des particules, mais plutôt celle de la distribution statistique – ou histogramme – des positions et vitesses (on parle de distribution cinétique). Il écrit ensuite une équation d’évolution pour cette distribution, qui tient compte à la fois du mouvement des particules et des collisions, ainsi que de la conservation de l’énergie (premier principe). Boltzmann découvre alors qu’une certaine caractéristique simple et globale de la solution de cette équation d’évolution croît au cours du temps (second principe !). La perte d’information microscopique est compensée par l’apparition d’un comportement macroscopique déterministe. Ce faisant, Boltzmann fait une découverte fondamentale : le hasard du modèle, résumé par une distribution, suit une loi déterministe. Ce qui est prévisible, c’est la distribution statistique de l’imprévisible. L’équation de Boltzmann fait penser à une équation d’évolution obtenue un siècle plus tôt par Leonhard Euler en mécanique des fluides.

(1) En langage moderne, il s'agit de molécules plutôt que d'atomes.

Le travail de Boltzmann en théorie cinétique des gaz, poursuivi notamment par Josiah Willard Gibbs, fait émerger une physique nouvelle : la physique statistique. L’œuvre de Boltzmann a encore aujourd’hui une influence considérable en physique mathématique avec, par exemple, les travaux actuels de Cédric Villani et de Laure Saint-Raymond. Par ailleurs, l’entropie statistique conçue par Boltzmann a été redécouverte avec grand profit par Claude Shannon, au cœur du XXe siècle, lors du développement de la théorie de l’information. Ce lien entre entropie et information avait déjà été identifié par Leó Szilárd. C’est semble-t-il John von Neumann qui a signalé judicieusement à Claude Shannon la proximité de son travail avec celui de Boltzmann. La théorie de l’information de Claude Shannon est fondamentale pour le codage et la compression de données, ainsi que pour les télécommunications numériques d’aujourd’hui.

L’idée de Boltzmann d’écrire une équation d’évolution déterministe pour une distribution décrivant la statistique du hasard est féconde. Cette vision mécaniste des aléas de la nature n’est pas sans rappeler celle de Charles Darwin, dont Boltzmann admirait l’œuvre. Elle s’exprime par la suite clairement au début du XXe siècle dans les travaux d’Andreï Markov sur les processus stochastiques, qualifiés aujourd’hui de « markoviens ».

Le début du XXe siècle voit également la victoire de l’atomisme avec les travaux d’Albert Einstein, Paul Langevin et Marian Smoluchowski sur le phénomène du mouvement brownien2 d’une particule immergée dans un fluide, soumise aux chocs incessants et aléatoires des molécules du fluide. Le « mouvement brownien » des mathématiques actuelles en est directement inspiré et constitue un processus stochastique markovien fondamental de la théorie des probabilités.

(2) Du nom du botaniste Robert Brown, qui a observé un grain de pollen au microscope.

La même veine se retrouve ensuite au cœur du XXe siècle, dans l’œuvre des grands probabilistes Andreï Kolmogorov, Kiyoshi Itō, Joseph Doob et Paul Lévy. De nos jours, la théorie moderne des probabilités est construite rigoureusement, au sein des mathématiques, sur un substrat de combinatoire et d’analyse, en cohérence notamment avec la statistique mathématique. La théorie des probabilités intervient dans la mathématisation de tous les phénomènes dans lesquels une notion d’aléa ou de bruit intervient, autant dire quasiment tous ! Elle engendre par ailleurs ses propres questions, de nature probabiliste, et fournit de plus à l’ensemble des mathématiques des concepts et des outils pour étudier les problèmes sous un angle nouveau.

Le XXe siècle est bien sûr aussi le siècle de la mécanique quantique, une théorie importante de la physique qui fait appel dès le départ à une interprétation probabiliste, alors même que la théorie des probabilités est encore en gestation en mathématiques ! En mécanique quantique, les concepts de position et de vitesse des particules élémentaires sont des distributions statistiques dont les dispersions sont typiquement antagonistes : on ne peut déterminer simultanément les deux avec précision ; c’est le fameux principe d’incertitude de Werner Heisenberg. Cette théorie physique, incomplète et controversée – en particulier par Einstein lorsqu’il écrit : Gott würfelt nicht (« Dieu ne joue pas aux dés ») – reste néanmoins d’une grande efficacité concrète. Dans le futur, l’avènement d’ordinateurs quantiques pourrait révolutionner l’informatique.

Le XXe siècle est enfin le siècle du projet Manhattan. C’est dans le sillage de ce projet, dans un laboratoire de recherche à Los Alamos, au Nouveau-Mexique, que Nicholas Metropolis et John von Neumann ont développé l’un des tous premiers ordinateurs, le Mathematical Analyzer, Numerator, Integrator, and Computer (MANIAC). C’est aussi à Los Alamos que Stanisław Ulam et John von Neumann ont mis au point l’algorithme de simulation aléatoire dit « de Monte-Carlo », qui révolutionnera les calculs numériques.

Mais qu’est-ce qu’un algorithme, au juste ?

Un algorithme est une procédure standardisée qui permet d’obtenir un résultat. Les mathématiques proposent des algorithmes pour construire des objets. Beaucoup de démonstrations mathématiques sont en réalité des algorithmes. À titre d’exemple, en géométrie plane, la méthode de construction de la médiatrice d’un segment à la règle et au compas est un algorithme. En arithmétique, le calcul du plus grand commun diviseur peut être effectué, par divisions euclidiennes successives, en utilisant l’algorithme d’Euclide. Encore plus simplement, la méthode pour calculer à la main ou poser une addition, une multiplication ou une division est un algorithme. L’informatique constitue de nos jours le versant algorithmique le plus concret des mathématiques. Un algorithme n’est rien d’autre qu’un programme exécutable par un humain ou une machine. Le boulier asiatique, la machine arithmétique de Blaise Pascal, la machine à différence puis la machine analytique de Charles Babbage sont des ancêtres remarquables des ordinateurs modernes.

De nos jours, les algorithmes sont le plus souvent exécutés par des ordinateurs et concernent des données numériques. À titre d’exemple, le format de fichier d’image JPEG ainsi que le format de fichier musical MP3 font appel, entre autres choses importantes, à un algorithme de compression de données dû à David Huffman. Cet algorithme implémente de manière constructive un théorème de Claude Shannon à base d’entropie. Le moteur de recherche de Google fait appel à un algorithme appelé PageRank basé sur l'utilisation d'une idée markovienne. Le programme spatial Apollo a fait appel à un algorithme de filtrage de données aléatoires de trajectoires markoviennes développé par Rudolf Kalman. L’algorithme de Monte-Carlo de Ulam et von Neumann permet de produire des nombres pseudo-aléatoires dont la distribution suit (parfois approximativement) une distribution statistique arbitrairement fixée, ce qui rend possibles des calculs approchés jusque-là inaccessibles, notamment pour des problèmes combinatoires complexes.

Beaucoup d’activités humaines sont quantifiées et optimisées. Cette optimisation se fait bien souvent en utilisant des algorithmes conçus et étudiés par des mathématiciens, parfois inspirés par des physiciens, programmés par des informaticiens et exécutés par des ordinateurs3. Tout récemment, des progrès spectaculaires ont été accomplis en intelligence artificielle et apprentissage automatique, domaines dans lesquels des données massives et de grande dimension ont fait leur apparition (images, sons, etc.). Les succès récents de l’apprentissage profond (deep learning), développé notamment par de grandes firmes comme Google4 et Facebook, doivent beaucoup non seulement à la puissance des ordinateurs actuels et à la présence d’immenses bases de données, mais aussi de manière cruciale au développement d’algorithmes d’optimisation stochastique.

(3) Certains scientifiques sont à la fois mathématiciens, physiciens et informaticiens.

(4) Le programme AlphaGo a battu récemment le champion du monde de jeu de go.

Algorithmes stochastiques

Nous vivons une époque dans laquelle la prise de conscience des risques et l’aversion au risque sont élevés. Dans quelle mesure peut-on ne rien laisser au hasard et maîtriser l’imprévisible ? La théorie des probabilités permet en quelque sorte de dompter l’aléatoire en le mathématisant, et ouvre la voie aux algorithmes. Les algorithmes stochastiques sont les algorithmes qui font intervenir une dose d’aléatoire. Cette dose d’aléatoire peut provenir des données du problème ou du déroulement de l’algorithme, l’un n’empêchant pas l’autre. Il se trouve que l’algorithme de simulation de Monte-Carlo de Ulam et von Neumann, évoqué précédemment, a inspiré un algorithme de simulation développé par Nicholas Metropolis à base de chaînes de Markov. Cet algorithme a suscité à son tour l’algorithme du recuit simulé, qui permet d’optimiser un coût arbitraire. Inspiré de la métallurgie, cet algorithme est très utilisé et fait toujours l’objet de recherches.

Pierre Monmarché

Les résultats de Pierre Monmarché sont motivés par l’étude et le développement d’algorithmes stochastiques, notamment d’algorithmes similaires au recuit simulé. Ils apportent en particulier une meilleure compréhension du comportement en temps long de processus stochastiques naturels inspirés des travaux de Markov. Parmi les concepts en jeu figurent ceux que Cédric Villani a développés dans le cadre d’une théorie dite « de l’hypocoercivité », inspirée à l’origine par la théorie cinétique des gaz de Boltzmann. Les résultats de Pierre Monmarché ont la particularité de mêler des univers et des influences multiples, entre théorie des probabilités, physique statistique, analyse des équations aux dérivées partielles et ingénierie. Ils sont reliés également à des processus stochastiques déterministes par morceaux, qui interviennent dans des modélisations mathématiques en biologie et en informatique. Ces travaux sont très appréciés et promettent de futurs développements passionnants. J’ai plusieurs fois rencontré Pierre Monmarché pendant sa thèse, à Toulouse, à Cracovie et à Paris. Son indépendance d’esprit, son enthousiasme, sa curiosité et sa ténacité m’ont beaucoup marqué. Ce sont les qualités reines d’un chercheur. Aussi est-ce avec un sentiment de grand honneur et beaucoup de plaisir que j’écris ces quelques lignes introductives à l’occasion de ce prix qui récompense ses recherches.

P.S. : ce texte est plus vague sur les algorithmes car cela fait l'objet du texte de Monmarché.

“The actual science of logic is conversant at present

only with things either certain, impossible or entirely doubtful,

none of which fortunately we have to reason on.

Therefore the true logic for this world is the calculus of Probabilities,

which takes account of the magnitude of the probability which is,

or ought to be, in a reasonable man’s mind.”

James Clerk Maxwell,

Lettre à Lewis Campbell, juillet 1850.

J'ai eu le plaisir d'écrire le texte ci-dessus pour introduire, en tant qu'«aîné», un texte de Pierre Monmarché, lauréat du Prix du Monde de la recherche 2015. Je remercie Cédric Villani pour sa confiance et les Éditions Le Pommier pour leur aimable autorisation à reproduire ce texte ici, à quelques détails près postérieurs à la publication.

Dans ce livre paru ce mois-ci aux Éditions Le Pommier, Cédric Villani présente les cinq lauréats du Prix du Monde de la recherche universitaire en sciences de la matière, de l’Univers et de la vie, remis en novembre 2015. Le jury a distingué, outre la qualité de leur thèse de doctorat et son originalité, les qualités de communication dont ils ont fait preuve, de même que l’intérêt que ces thèses peuvent avoir pour le grand public.

Les thèmes sont : Les neiges du plateau Antarctique (physique du climat) par Quentin Libois, La mécanique de la cellule et œuf mollet (biologie), par Agathe Chaigne, La lutte contre les maladies infectieuses : la piste de la génétique humaine (génétique), par Quentin Vincent, Le cerveau sans mode d’emploi (interface homme machine), par Jonathan Grizou, Le bon dosage de l’aléatoire dans nos recherches (mathématiques), par Pierre Monmarché.

Les lauréats racontent les raisons de leur engagement, les conditions, l’environnement et le déroulement de leur travail aussi bien que son explication proprement dite, l’exposé de ses résultats et de ce que l’on peut en attendre. Ces exposés sont précédés de présentations d’« aînés » qui resituent les résultats de ce premier travail de recherche dans le tissus scientifique actuel, en composant ainsi un paysage de la science contemporaine.

Bonjour,

Un grand merci pour ce travail de pédagogie pour non initié.